服务器双CPU叠加运行的原理是什么?

- 科技动态

- 2025-07-07

- 59

服务器在处理大量数据和运行复杂应用时,性能需求极大,而双CPU叠加运行技术正能够显著提升服务器的计算能力和效率。通过理解双CPU叠加运行的原理,企业能够更有效地规划和升级其IT基础设施。本文将深入探讨这一技术的具体运作机制,并提供一些实用的指导。

一、双CPU叠加运行的基本概念

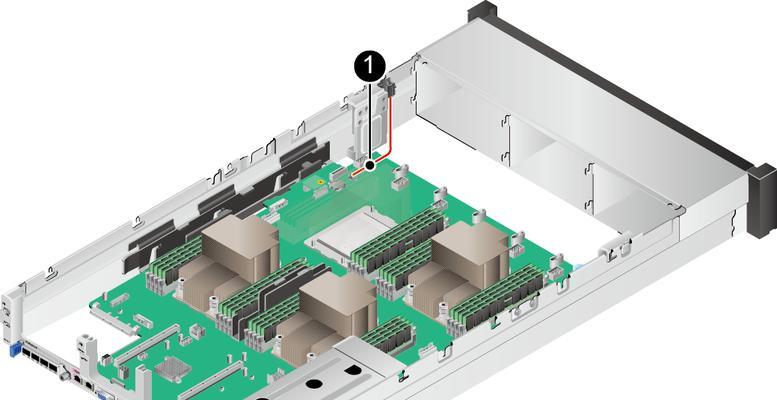

双CPU叠加运行,通常被称作“双路服务器”或“双处理器系统”,指的是在一台服务器中安装两个中央处理器(CPU)并行工作。这种设计允许系统在执行计算任务时分摊负载,提高处理速度和数据吞吐能力。在理解其运作之前,我们需要明确几个关键点:

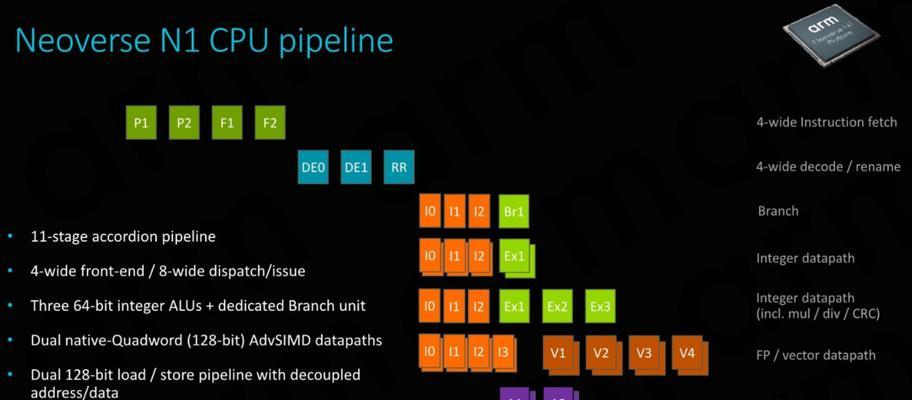

CPU核心:现代CPU通常包含多个核心,它们能够同时执行多个线程,从而提高处理性能。

并行计算:通过将任务拆分为多个小部分,在多个核心上同时处理,可以显著减少处理时间。

多任务处理:一个双CPU系统可以在两个处理器之间分配任务,实现更高的效率和响应速度。

二、双CPU叠加运行的工作原理

双CPU叠加运行的核心原理在于利用多核心处理器之间的协作,来完成更复杂的计算任务。具体工作流程如下:

1.负载分配

当双CPU服务器接收到计算任务时,操作系统会根据任务需求以及CPU的当前负载,智能分配任务到两个处理器上。这样可以确保两个CPU都不会出现空闲或过度负载的情况。

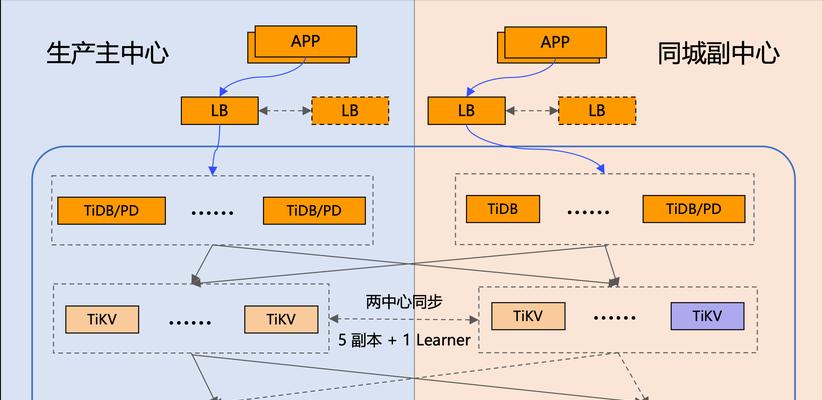

2.数据共享和交换

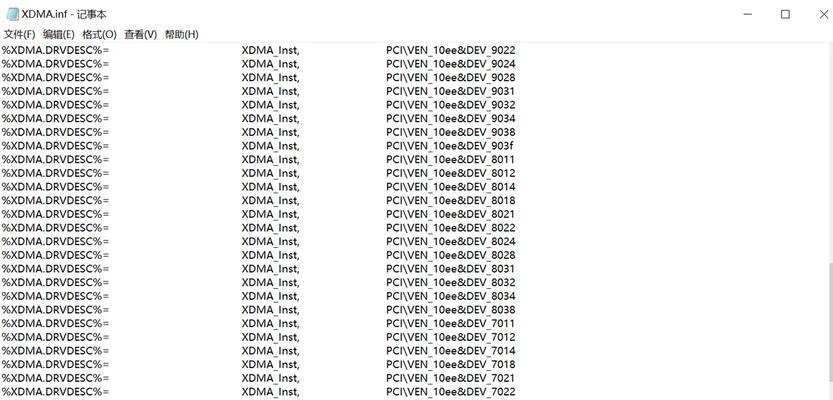

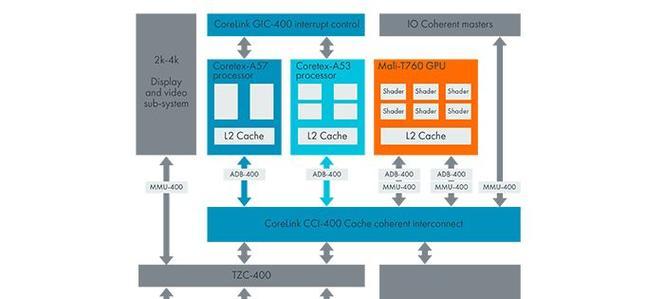

双CPU系统中,两个处理器通常会通过高速总线或专用通道进行数据共享和交换。它们可能共享内存控制器、缓存以及I/O接口,这有助于协调两个CPU的工作,以达到更佳的性能。

3.任务同步

为了确保数据一致性,双CPU系统中的处理器必须能够在执行并行任务时进行同步。它们之间需要通过锁机制、中断信号或其它同步方法,保证任务协调一致,避免数据冲突或重复计算。

4.高级协调技术

现代双CPU服务器可能采用高级技术,如Intel的超线程技术(Hyper-Threading)或AMD的多核心协调技术。这些技术能够进一步优化CPU资源的使用,提高系统的整体性能。

三、双CPU叠加运行的优势

双CPU叠加运行技术为服务器带来的优势是多方面的:

性能提升:双CPU能够分担计算工作,显著提高数据处理速度和系统效率。

任务并发:允许系统同时处理更多任务,增强多任务处理能力。

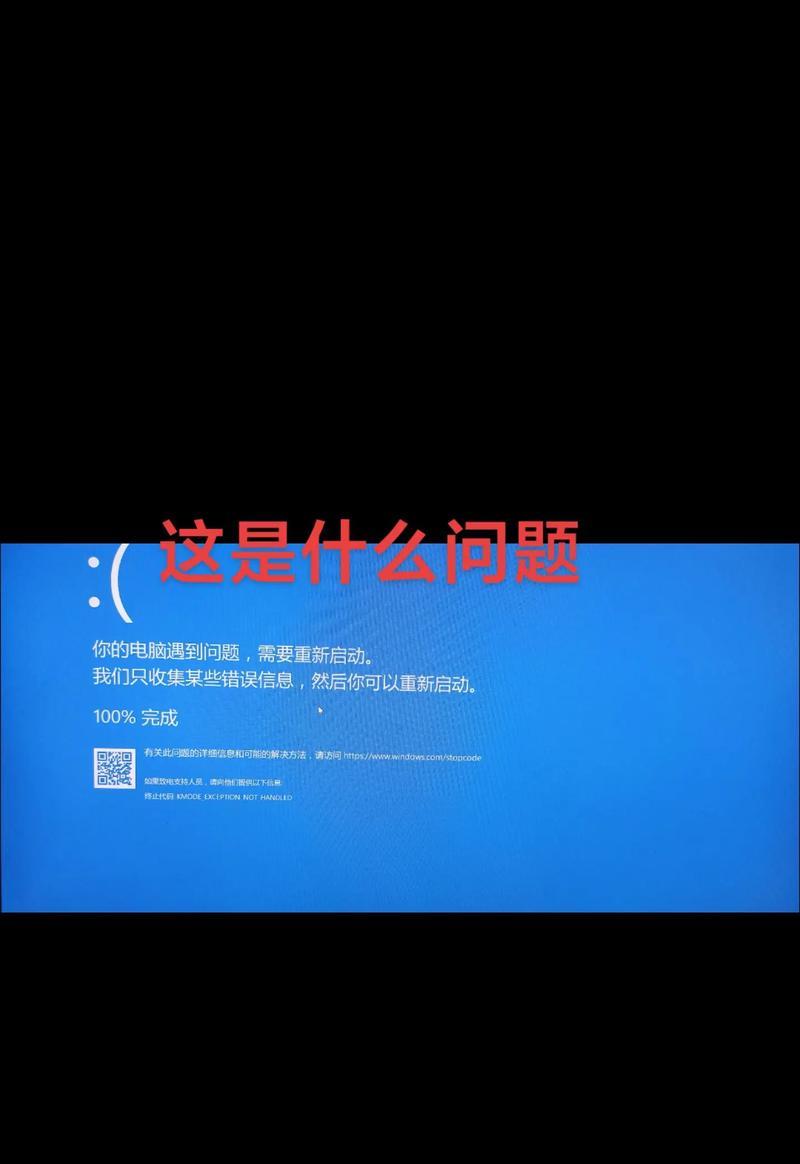

冗余设计:一个CPU在故障时,另一个CPU可以接管其工作,从而提高系统的可靠性。

扩展性:双CPU设计为未来升级或添加更多CPU提供了方便。

四、实践中的应用

在实际应用中,双CPU叠加运行系统广泛应用于需要高计算能力的场合:

数据库服务器:处理大量并发请求时需要高速的计算和处理能力。

云计算平台:为多个虚拟机提供计算资源时,需要强大的CPU支撑。

科学计算:在需要进行大量数值计算的研究领域,双CPU系统能够大幅缩短计算时间。

五、常见问题解答

1.双CPU服务器是否一定比单CPU服务器快?

双CPU服务器在处理并行任务时表现更出色,但并非所有任务都能有效利用双处理器的优势。对于单线程或轻负载的应用,单CPU服务器可能已经足够使用。

2.服务器升级时如何选择双CPU系统?

升级服务器时,应考虑现有软件对多核心的优化程度、预算限制以及未来的扩展需求。通常建议选择与现有系统兼容的最新一代CPU,并考虑主板和内存的升级潜力。

六、结论

双CPU叠加运行技术为服务器提供了强大的计算支持,对于需要处理大量数据的企业级应用尤为重要。通过合理利用双CPU技术,企业不仅能够提升业务处理速度,还能增强系统的稳定性和扩展性。理解并应用好这一技术,对于构建高效能服务器环境至关重要。

通过本文的介绍,相信读者已经对双CPU叠加运行的原理有了深入的理解,并能在实际操作中做出更为明智的决策。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.zlyjx.com/article-11988-1.html